# 4. ClickHouse 表引擎

表引擎是 ClickHouse 的一大特色。可以说, 表引擎决定了如何存储表的数据。包括:

- 数据的存储方式和位置,写到哪里以及从哪里读取数据;

- 支持哪些查询以及如何支持;

- 并发数据访问;

- 索引的使用(如果存在);

- 是否可以执行多线程请求;

- 数据复制参数;

表引擎的使用方式就是必须显式在创建表时定义该表使用的引擎,以及引擎使用的相关参数。

WARNING

特别注意:引擎的名称大小写敏感。

# 4.1 TinyLog

以列文件的形式保存在磁盘上,不支持索引,没有并发控制。一般保存少量数据的小表, 生产环境上作用有限。可以用于平时练习测试用。

CREATE TABLE t_tinylog ( id String, name String) ENGINE=TinyLog;

# 4.2 Memory

内存引擎,数据以未压缩的原始形式直接保存在内存当中,服务器重启数据就会消失。 读写操作不会相互阻塞,不支持索引。简单查询下有非常非常高的性能表现(超过 10G/s)。

一般用到它的地方不多,除了用来测试,就是在需要非常高的性能,同时数据量又不太大(上限大概 1 亿行)的场景。

# 4.3 MergeTree

ClickHouse 中最强大的表引擎当属 MergeTree 引擎及该系列(MergeTree)中的其他引擎,支持索引和分区,地位可以相当于 Innodb 之于 MySQL。而且基于 MergeTree, 还衍生除了很多小弟,也是非常有特色的引擎。

# 4.3.1 基本使用

建表

CREATE TABLE t_order_mt( id UInt32, sku_id String, total_amount Decimal(16,2), create_time Datetime ) ENGINE =MergeTree PARTITION BY toYYYYMMDD(create_time) PRIMARY KEY (id) ORDER BY (id,sku_id);插入数据

INSERT INTO t_order_mt VALUES (101,'sku_001',1000.00,'2020-06-01 12:00:00') , (102,'sku_002',2000.00,'2020-06-01 11:00:00'), (102,'sku_004',2500.00,'2020-06-01 12:00:00'), (102,'sku_002',2000.00,'2020-06-01 13:00:00'), (102,'sku_002',12000.00,'2020-06-01 13:00:00'), (102,'sku_002',600.00,'2020-06-02 12:00:00');查询数据

SELECT * FROM t_order_mt;输出:

SELECT * FROM t_order_mt Query id: 2a5e5ca0-9597-4f57-acb9-1b9dbb0ffaa8 ┌──id─┬─sku_id──┬─total_amount─┬─────────create_time─┐ │ 101 │ sku_001 │ 1000.00 │ 2020-06-01 12:00:00 │ │ 102 │ sku_002 │ 2000.00 │ 2020-06-01 11:00:00 │ │ 102 │ sku_002 │ 2000.00 │ 2020-06-01 13:00:00 │ │ 102 │ sku_002 │ 12000.00 │ 2020-06-01 13:00:00 │ │ 102 │ sku_004 │ 2500.00 │ 2020-06-01 12:00:00 │ └─────┴─────────┴──────────────┴─────────────────────┘ ┌──id─┬─sku_id──┬─total_amount─┬─────────create_time─┐ │ 102 │ sku_002 │ 600.00 │ 2020-06-02 12:00:00 │ └─────┴─────────┴──────────────┴─────────────────────┘ 6 rows in set. Elapsed: 0.331 sec.

# 4.3.2 分区 partition by(可选项)

作用

学过 hive 的应该都不陌生,分区的目的主要是降低扫描的范围,优化查询速度。

默认

如果不填分区,只会使用一个分区。

分区目录

MergeTree 是以列文件 + 索引文件 + 表定义文件组成的,但是如果设定了分区那么这些文件就会保存到不同的分区目录中。

并行

分区后,面对设计跨分区的查询统计,ClickHouse 会以分区为单位并行处理。

数据写入与分区合并

任何一个批次的数据写入都会产生一个临时分区,不会纳入任何一个已有的分区。写入后的某个时刻(大概 10-15 分钟后),ClickHouse 会自动执行合并操作(等不及也可以手动通过 optimize 执行),把临时分区的数据,合并到已有分区中。

OPTIMIZE TABLE xxx final;示例

在上述例子的基础上,再插入数据:

INSERT INTO t_order_mt VALUES (101,'sku_001',1000.00,'2020-06-01 12:00:00') , (102,'sku_002',2000.00,'2020-06-01 11:00:00'), (102,'sku_004',2500.00,'2020-06-01 12:00:00'), (102,'sku_002',2000.00,'2020-06-01 13:00:00'), (102,'sku_002',12000.00,'2020-06-01 13:00:00'), (102,'sku_002',600.00,'2020-06-02 12:00:00');查看数据,会发现它们并没有被纳入任何分区:

SELECT * FROM t_order_mt Query id: dbec28cb-0ca0-4fd8-adc1-99ea4d8fe1ff ┌──id─┬─sku_id──┬─total_amount─┬─────────create_time─┐ │ 101 │ sku_001 │ 1000.00 │ 2020-06-01 12:00:00 │ │ 102 │ sku_002 │ 2000.00 │ 2020-06-01 11:00:00 │ │ 102 │ sku_002 │ 2000.00 │ 2020-06-01 13:00:00 │ │ 102 │ sku_002 │ 12000.00 │ 2020-06-01 13:00:00 │ │ 102 │ sku_004 │ 2500.00 │ 2020-06-01 12:00:00 │ └─────┴─────────┴──────────────┴─────────────────────┘ ┌──id─┬─sku_id──┬─total_amount─┬─────────create_time─┐ │ 101 │ sku_001 │ 1000.00 │ 2020-06-01 12:00:00 │ │ 102 │ sku_002 │ 2000.00 │ 2020-06-01 11:00:00 │ │ 102 │ sku_002 │ 2000.00 │ 2020-06-01 13:00:00 │ │ 102 │ sku_002 │ 12000.00 │ 2020-06-01 13:00:00 │ │ 102 │ sku_004 │ 2500.00 │ 2020-06-01 12:00:00 │ └─────┴─────────┴──────────────┴─────────────────────┘ ┌──id─┬─sku_id──┬─total_amount─┬─────────create_time─┐ │ 102 │ sku_002 │ 600.00 │ 2020-06-02 12:00:00 │ └─────┴─────────┴──────────────┴─────────────────────┘ ┌──id─┬─sku_id──┬─total_amount─┬─────────create_time─┐ │ 102 │ sku_002 │ 600.00 │ 2020-06-02 12:00:00 │ └─────┴─────────┴──────────────┴─────────────────────┘ 12 rows in set. Elapsed: 0.008 sec.手动合并:

OPTIMIZE TABLE t_order_mt FINAL;再次查询:

SELECT * FROM t_order_mt Query id: 2386e7a2-f2c4-41b2-b96d-06dfb3d202cd ┌──id─┬─sku_id──┬─total_amount─┬─────────create_time─┐ │ 101 │ sku_001 │ 1000.00 │ 2020-06-01 12:00:00 │ │ 101 │ sku_001 │ 1000.00 │ 2020-06-01 12:00:00 │ │ 102 │ sku_002 │ 2000.00 │ 2020-06-01 11:00:00 │ │ 102 │ sku_002 │ 2000.00 │ 2020-06-01 13:00:00 │ │ 102 │ sku_002 │ 12000.00 │ 2020-06-01 13:00:00 │ │ 102 │ sku_002 │ 2000.00 │ 2020-06-01 11:00:00 │ │ 102 │ sku_002 │ 2000.00 │ 2020-06-01 13:00:00 │ │ 102 │ sku_002 │ 12000.00 │ 2020-06-01 13:00:00 │ │ 102 │ sku_004 │ 2500.00 │ 2020-06-01 12:00:00 │ │ 102 │ sku_004 │ 2500.00 │ 2020-06-01 12:00:00 │ └─────┴─────────┴──────────────┴─────────────────────┘ ┌──id─┬─sku_id──┬─total_amount─┬─────────create_time─┐ │ 102 │ sku_002 │ 600.00 │ 2020-06-02 12:00:00 │ │ 102 │ sku_002 │ 600.00 │ 2020-06-02 12:00:00 │ └─────┴─────────┴──────────────┴─────────────────────┘ 12 rows in set. Elapsed: 0.004 sec.

补充:分区的存储

[root@localhost t_order_mt]# pwd

/var/lib/clickhouse/data/default/t_order_mt

[root@localhost t_order_mt]# ll

total 4

drwxr-x--- 2 clickhouse clickhouse 203 Mar 1 06:52 20200601_1_3_1

drwxr-x--- 2 clickhouse clickhouse 203 Mar 1 06:52 20200602_2_4_1

drwxr-x--- 2 clickhouse clickhouse 6 Mar 1 06:39 detached

-rw-r----- 1 clickhouse clickhouse 1 Mar 1 06:39 format_version.txt

[root@localhost t_order_mt]# cd 20200601_1_3_1/

[root@localhost 20200601_1_3_1]# ll

total 36

-rw-r----- 1 clickhouse clickhouse 260 Mar 1 06:52 checksums.txt

-rw-r----- 1 clickhouse clickhouse 118 Mar 1 06:52 columns.txt

-rw-r----- 1 clickhouse clickhouse 2 Mar 1 06:52 count.txt

-rw-r----- 1 clickhouse clickhouse 217 Mar 1 06:52 data.bin

-rw-r----- 1 clickhouse clickhouse 144 Mar 1 06:52 data.mrk3

-rw-r----- 1 clickhouse clickhouse 10 Mar 1 06:52 default_compression_codec.txt

-rw-r----- 1 clickhouse clickhouse 8 Mar 1 06:52 minmax_create_time.idx

-rw-r----- 1 clickhouse clickhouse 4 Mar 1 06:52 partition.dat

-rw-r----- 1 clickhouse clickhouse 8 Mar 1 06:52 primary.idx

分区的文件夹名称:PartitionId_MinBlockNum_MaxBlockNum_Level(分区值_最小分区块编号_最大分区块编号_合并层级)

PartitionId

数据分区 ID,数据分区规则由分区 ID 决定,分区 ID 由 PARTITION BY 分区键决定。根据分区键字段类型,ID生成规则可分为:

未定义分区键

没有定义 PARTITION BY,默认生成一个目录名为

all的数据分区,所有数据均存放在all目录下。整型分区键

分区键为整型,那么直接用该整型值的字符串形式做为分区 ID。

日期类分区键

分区键为日期类型,或者可以转化成日期类型。

其他类型分区键

String、Float 类型等,通过 128 位的

Hash算法取其 Hash 值作为分区 ID。

MinBlockNum

最小分区块编号,自增类型,从 1 开始向上递增。每产生一个新的目录分区就向上递增一个数字。

MaxBlockNum

最大分区块编号,新创建的分区 MinBlockNum 等于 MaxBlockNum 的编号。

Level

合并的层级,被合并的次数。合并次数越多,层级值越大。

分区目录下的各个文件:

bin 文件:数据文件

mrk 文件:标记文件

标记文件在 idx 索引文件和 bin 数据文件之间起到了桥梁作用。

以 mrk2 结尾的文件,表示该表启用了自适应索引间隔。

primary.idx 文件:主键索引文件,用于加快查询效率。

minmax_create_time.idx:分区键的最大最小值。

checksums.txt:校验文件,用于校验各个文件的正确性。存放各个文件的 size 以及 hash 值。

# 4.3.3 主键 primary key(可选项)

ClickHouse 中的主键,只提供数据的一级索引,没有提供唯一约束。这意味着是可以存在相同的 primary key 的数据的。

主键的设定主要依据是查询语句中的 where 条件。

根据条件通过对主键进行某种形式的二分查找,能够定位到对应的 index granularity,避免了全表扫描。

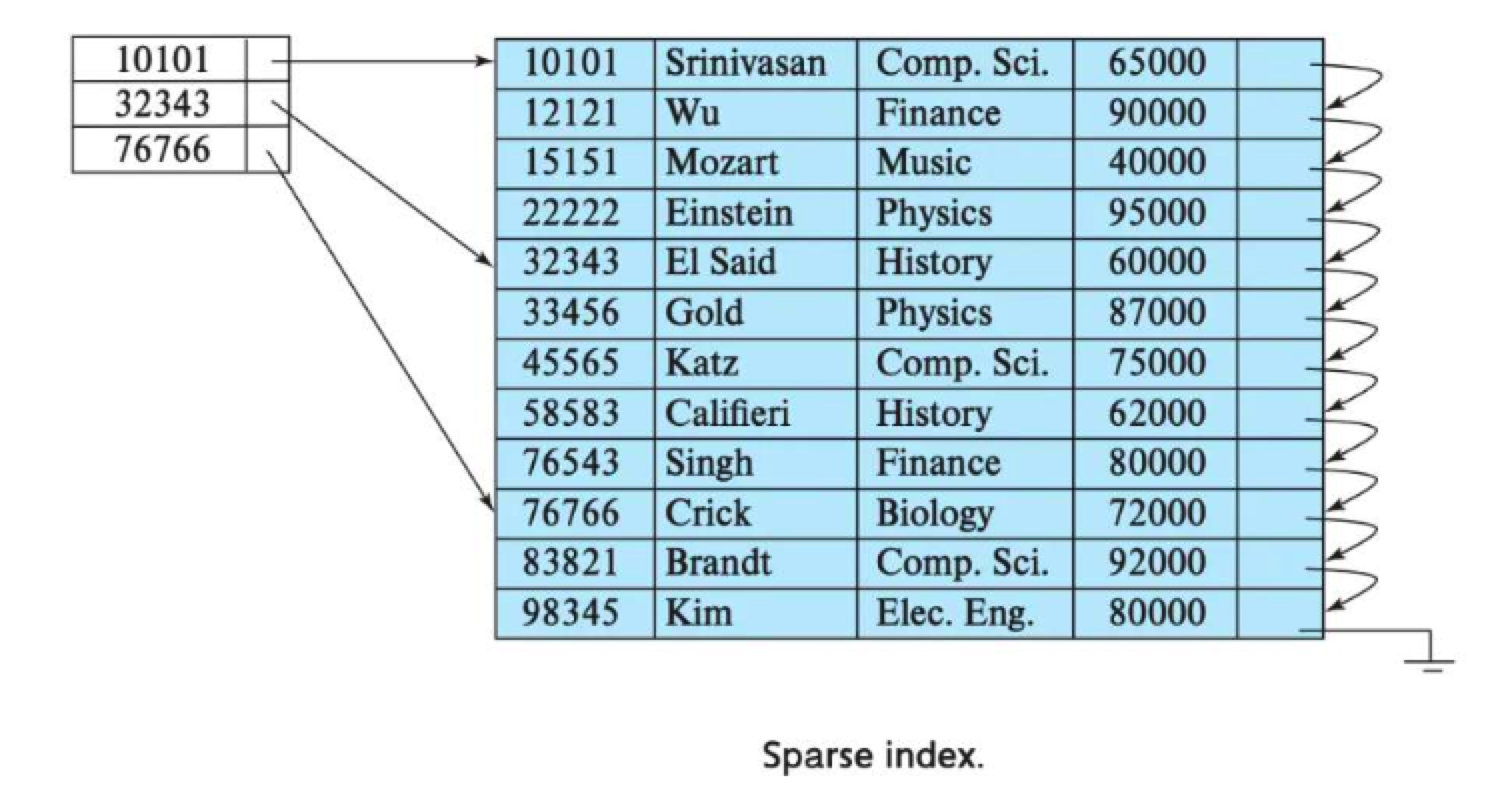

index granularity:直接翻译的话就是索引粒度,指在稀疏索引中两个相邻索引对应数据的间隔。

ClickHouse 中的 MergeTree 默认是 8192。官方不建议修改这个值,除非该列存在大量重复值,比如在一个分区中几万行才有一个不同数据。

ClickHouse 中的索引粒度采用的是:稀疏索引:

稀疏索引的好处就是可以用很少的索引数据,定位更多的数据,代价就是只能定位到索引粒度的第一行,然后再进行进行扫描。

# 4.3.4 排序 order by(必选项)

order by 设定了分区内的数据按照哪些字段顺序进行有序保存。

order by 是 MergeTree 中唯一一个必填项,甚至比 primary key 还重要,因为当用户不设置主键的情况,很多处理会依照 order by 的字段进行处理(比如去重和汇总)。

注意

主键必须是 order by 字段的前缀字段。

比如 order by 字段是 (id,sku_id),那么主键必须是 id 或者 (id,sku_id)。

# 4.3.5 二级索引

二级索引就是对一级索引再次建索引。

CREATE TABLE t_order_mt2(

id UInt32,

sku_id String,

total_amount Decimal(16,2),

create_time Datetime,

INDEX a total_amount TYPE minmax GRANULARITY 5

) ENGINE=MergeTree

PARTITION BY toYYYYMMDD(create_time)

PRIMARY KEY (id)

ORDER BY (id, sku_id);

- INDEX a total_amount TYPE minmax GRANULARITY 5

- INDEX:关键字

- a:索引名称

- total_amount:字段名

- TYPE:关键字

- minmax:二级索引类型

- GRANULARITY:设定二级索引对于一级索引粒度的粒度

- 5:每 5 个建一个索引

# 4.3.6 数据 TTL

TTL 即 Time To Live,MergeTree 提供了可以管理数据表或者列的生命周期的功能。

列级

CREATE TABLE t_order_mt3( id UInt32, sku_id String, total_amount Decimal(16,2) TTL create_time+interval 10 SECOND, create_time Datetime ) ENGINE=MergeTree PARTITION BY toYYYYMMDD(create_time) PRIMARY KEY (id) ORDER BY (id, sku_id);表级

ALTER TABLE t_order_mt3 MODIFY TTL create_time + INTERVAL 10 SECOND;

# 4.4 ReplacingMergeTree

ReplacingMergeTree 是 MergeTree 的一个变种,它存储特性完全继承 MergeTree,只是多了一个 去重 的功能。 尽管 MergeTree 可以设置主键,但是 primary key 其实没有唯一约束的功能。如果你想处理掉重复的数据,可以借助这个 ReplacingMergeTree。

# 4.4.1 去重时机

数据的去重只会在合并的过程中出现。合并会在未知的时间在后台进行,所以你无法预先作出计划。有一些数据可能仍未被处理。

# 4.4.2 去重范围

如果表经过了分区,去重只会在分区内部进行去重,不能执行跨分区的去重。所以 ReplacingMergeTree 能力有限, ReplacingMergeTree 适用于在后台清除重复的数据以节省空间,但是它不保证没有重复的数据出现。

# 4.4.3 案例演示

建表

CREATE TABLE t_order_rmt ( `id` UInt32, `sku_id` String, `total_amount` Decimal(16, 2), `create_time` Datetime ) ENGINE = ReplacingMergeTree(create_time) PARTITION BY toYYYYMMDD(create_time) PRIMARY KEY (id) ORDER BY (id, sku_id);ReplacingMergeTree() 填入的参数为版本字段,重复数据保留版本字段值最大的。 如果不填版本字段,默认按照插入顺序保留最后一条。

插入数据

INSERT INTO t_order_rmt VALUES (101,'sku_001',1000.00,'2020-06-01 12:00:00') , (102,'sku_002',2000.00,'2020-06-01 11:00:00'), (102,'sku_004',2500.00,'2020-06-01 12:00:00'), (102,'sku_002',2000.00,'2020-06-01 13:00:00'), (102,'sku_002',12000.00,'2020-06-01 13:00:00'), (102,'sku_002',600.00,'2020-06-02 12:00:00');执行第一次查询

SELECT * FROM t_order_rmt Query id: e6dbee31-0efe-4f71-895a-37b0ffadc351 ┌──id─┬─sku_id──┬─total_amount─┬─────────create_time─┐ │ 101 │ sku_001 │ 1000.00 │ 2020-06-01 12:00:00 │ │ 102 │ sku_002 │ 2000.00 │ 2020-06-01 11:00:00 │ │ 102 │ sku_002 │ 2000.00 │ 2020-06-01 13:00:00 │ │ 102 │ sku_002 │ 12000.00 │ 2020-06-01 13:00:00 │ │ 102 │ sku_004 │ 2500.00 │ 2020-06-01 12:00:00 │ └─────┴─────────┴──────────────┴─────────────────────┘ ┌──id─┬─sku_id──┬─total_amount─┬─────────create_time─┐ │ 102 │ sku_002 │ 600.00 │ 2020-06-02 12:00:00 │ └─────┴─────────┴──────────────┴─────────────────────┘ 6 rows in set. Elapsed: 0.009 sec.手动合并

OPTIMIZE TABLE t_order_rmt FINAL;再执行一次查询

SELECT * FROM t_order_rmt Query id: 095b8af2-2db9-48b7-b4ed-84d2a0827d96 ┌──id─┬─sku_id──┬─total_amount─┬─────────create_time─┐ │ 101 │ sku_001 │ 1000.00 │ 2020-06-01 12:00:00 │ │ 102 │ sku_002 │ 12000.00 │ 2020-06-01 13:00:00 │ │ 102 │ sku_004 │ 2500.00 │ 2020-06-01 12:00:00 │ └─────┴─────────┴──────────────┴─────────────────────┘ ┌──id─┬─sku_id──┬─total_amount─┬─────────create_time─┐ │ 102 │ sku_002 │ 600.00 │ 2020-06-02 12:00:00 │ └─────┴─────────┴──────────────┴─────────────────────┘ 4 rows in set. Elapsed: 0.003 sec.结论

- 实际上是使用

order by字段作为唯一键; - 去重不能跨分区;

- 只有同一批插入(新版本)或合并分区时才会进行去重;

- 认定重复的数据保留,版本字段值最大的;

- 如果版本字段相同则按插入顺序保留最后一笔;

- 实际上是使用

# 4.5 SummingMergeTree

对于不查询明细,只关心以维度进行汇总聚合结果的场景。如果只使用普通的 MergeTree 的话,无论是存储空间的开销,还是查询时临时聚合的开销都比较大。

ClickHouse 为了这种场景,提供了一种能够“预聚合”的引擎 SummingMergeTree。

创建表

CREATE TABLE t_order_smt ( `id` UInt32, `sku_id` String, `total_amount` Decimal(16, 2), `create_time` Datetime ) ENGINE = SummingMergeTree(total_amount) PARTITION BY toYYYYMMDD(create_time) PRIMARY KEY (id) ORDER BY (id, sku_id)插入数据

INSERT INTO t_order_smt VALUES (101,'sku_001',1000.00,'2020-06-01 12:00:00'), (102,'sku_002',2000.00,'2020-06-01 11:00:00'), (102,'sku_004',2500.00,'2020-06-01 12:00:00'), (102,'sku_002',2000.00,'2020-06-01 13:00:00'), (102,'sku_002',12000.00,'2020-06-01 13:00:00'), (102,'sku_002',600.00,'2020-06-02 12:00:00');执行第一次查询

SELECT * FROM t_order_smt FINAL;输出:

SELECT * FROM t_order_smt Query id: ea1c76ba-33ce-4f91-8aa2-08042f0d2fad ┌──id─┬─sku_id──┬─total_amount─┬─────────create_time─┐ │ 101 │ sku_001 │ 1000.00 │ 2020-06-01 12:00:00 │ │ 102 │ sku_002 │ 2000.00 │ 2020-06-01 11:00:00 │ │ 102 │ sku_002 │ 2000.00 │ 2020-06-01 13:00:00 │ │ 102 │ sku_002 │ 12000.00 │ 2020-06-01 13:00:00 │ │ 102 │ sku_004 │ 2500.00 │ 2020-06-01 12:00:00 │ └─────┴─────────┴──────────────┴─────────────────────┘ ┌──id─┬─sku_id──┬─total_amount─┬─────────create_time─┐ │ 102 │ sku_002 │ 600.00 │ 2020-06-02 12:00:00 │ └─────┴─────────┴──────────────┴─────────────────────┘ 4 rows in set. Elapsed: 0.003 sec.手动合并

OPTIMIZE TABLE t_order_smt FINAL;再执行一次查询

SELECT * FROM t_order_smt Query id: ea1c76ba-33ce-4f91-8aa2-08042f0d2fad ┌──id─┬─sku_id──┬─total_amount─┬─────────create_time─┐ │ 101 │ sku_001 │ 1000.00 │ 2020-06-01 12:00:00 │ │ 102 │ sku_002 │ 16000.00 │ 2020-06-01 11:00:00 │ │ 102 │ sku_004 │ 2500.00 │ 2020-06-01 12:00:00 │ └─────┴─────────┴──────────────┴─────────────────────┘ ┌──id─┬─sku_id──┬─total_amount─┬─────────create_time─┐ │ 102 │ sku_002 │ 600.00 │ 2020-06-02 12:00:00 │ └─────┴─────────┴──────────────┴─────────────────────┘ 4 rows in set. Elapsed: 0.003 sec.结论

- 以 SummingMergeTree() 中指定的列作为汇总数据列;

- 可以填写多列,必须是数字列,如果不填,以所有非维度列且为数字列的字段为汇总数据列;

- 以 order by 的列为准,作为维度列;

- 其他的列按插入顺序保留第一行;

- 不在一个分区的数据不会被聚合;

- 只有在同一批次插入(新版本)或分片合并时才会进行聚合;

使用场景

设计聚合表的话,唯一键值、流水号可以去掉,所有字段全部是维度、度量或者时间戳。

问题

能不能直接执行以下 SQL 得到汇总值?

SELECT total_amount FROM XXX WHERE province_name=’’ AND create_date=’xxx’不行,可能会包含一些还没来得及聚合的临时明细。

如果要是获取汇总值,还是需要使用 sum 进行聚合,这样效率会有一定的提高,但本身 ClickHouse 是列式存储的,效率提升有限,不会特别明显。

SELECT SUM(total_amount) FROM province_name=’’ AND create_date=‘xxx’